Zumindest diejenigen unter uns, die an Tech-News interessiert sind und entsprechende Nachrichten-Updates verfolgen, werden geradezu überrannt mit immer neuen Anwendungen, Verbesserungen und Versprechungen rund um Chat-GPT und Konsorten.

Warum eigentlich?

KI ist doch schon seit ca. 60 Jahren ein Begriff und bereits davor Forschungsgegenstand. Was macht den Unterschied aus? Warum reiten wir gerade eine neue Welle des KI-Hypes?

Fangen wir vorne an.

Zunächst handelt es sich bei Chatbots um eine von vielen KI-Anwendungen. Das maschinelle Lernen hat seinen Ursprung in der Statistik und dient der Analyse von Daten in Form von überwachten, unüberwachten oder verstärkenden Lernverfahren. Chatbots sind eine Anwendung dieser Konzepte, die auf natürlicher Sprache basiert. Es handelt sich um sogenannte generative Modelle, die auf Basis von Texten trainiert werden und dann selbst Texte generieren können: Large Language Models (LLM).

Eine Erklärung, warum gerade jetzt so viel über Chatbots berichtet wird, ist die Tatsache, dass LLMs in den letzten Jahren immer besser geworden sind. Das liegt vor allem an der Verfügbarkeit von immer größeren Datenmengen, die für das Training der Modelle verwendet werden können und an der Verfügbarkeit von immer mehr Rechenleistung.

Der Grund allerdings, warum LLMs so eine große Verbreitung finden, ist die Zugänglichkeit. Mit Sprachmodellen ist es für jeden möglich, mit einer Anwendung der künstlichen Intelligenz zu interagieren. Es sind keine besonderen Hilfsmittel oder gar Programmierkenntnisse erforderlich. Im Gegenteil! Die KI hilft bei der Erstellung von Programmen, Texten, Hausaufgaben…

Diese Tatsache, die niederschwellige Interaktion mit generativen Modellen, stellt eine großartige Chance dar: Die Demokratisierung von Wissen, Können und Kreativität.

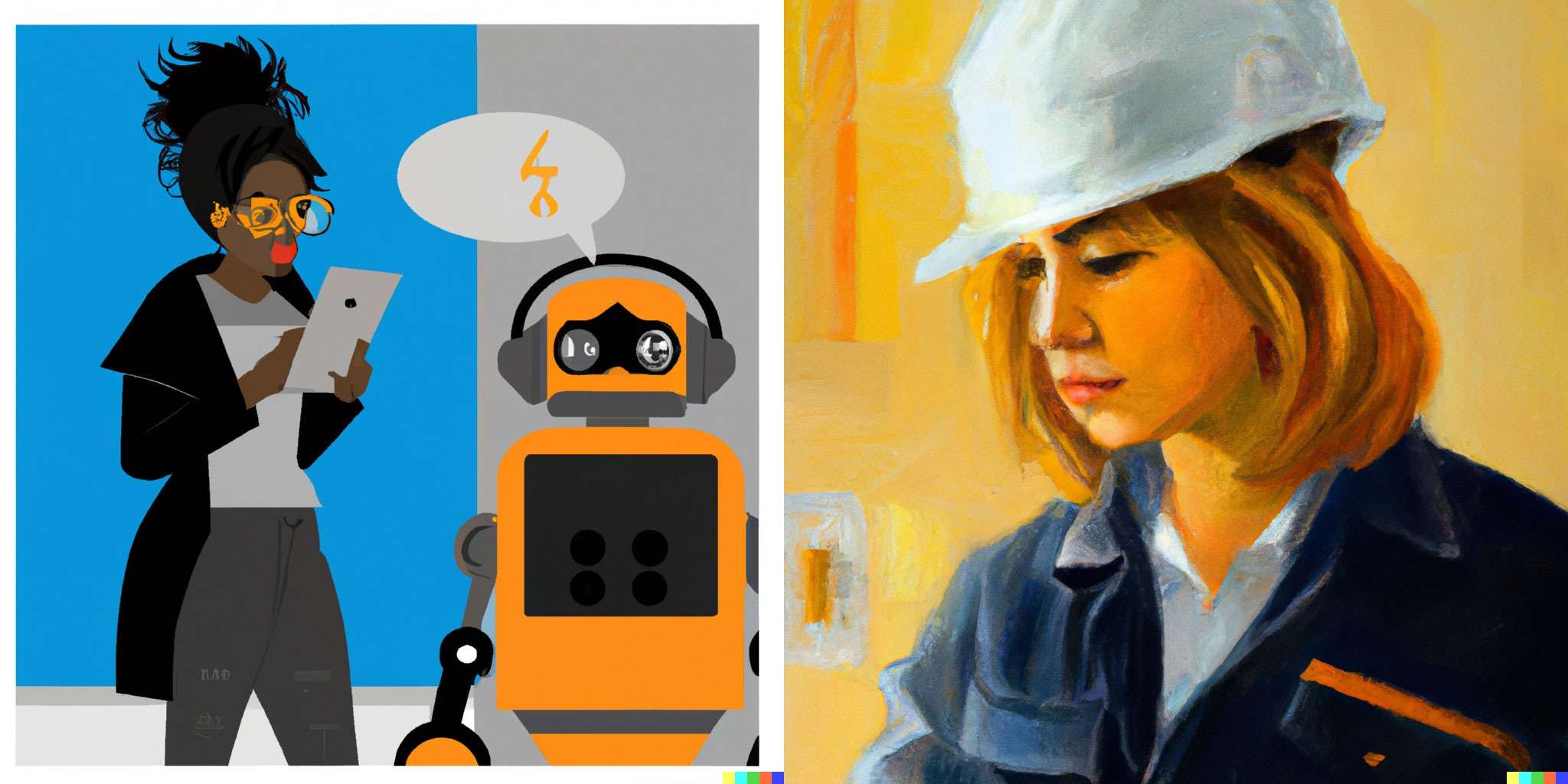

Wie häufig hindern uns mangelnde Erfahrung oder Zugang zu bestimmten Technologien daran, unsere Ideen umzusetzen? Wie oft haben wir uns schon gewünscht, eine bestimmte Fähigkeit zu besitzen, um ein Problem zu lösen? Sprachmodelle, insbesondere in ihrer in spezifische Anwendungen integrierten Form, können uns dabei helfen, diese Hürden zu überwinden.

Selbst ich, die ich als Maschinenbauingenieurin keine nennenswerte musische Begabung habe, kann mit Hilfe sprachbasierter künstlicher Intelligenz Bilder nach dem Vorbild alter Meister generieren. Oder Videos. Oder Gedichte.

Female mechanical engineer with a pearl earring by Jan Vermeer

„Demokratisierung von Wissen“ – das kommt uns doch bekannt vor: Genau das ist das Nutzenversprechen des Internets. Während dieses Versprechen theoretisch nach wie vor gegeben ist, helfen uns in der Praxis Filtersysteme dabei, die schiere Masse an Informationen zu bewältigen. Während wir fröhlich Sprachmodelle nutzen, um uns Einkaufslisten und Rezeptvorschläge für das romantische Abendessen generieren zu lassen, werden gerade in Bezug auf Kunst Copyright-Verletzungen diskutiert oder aber neue Geschäftsmodelle geschaffen. Beispielsweise argumentieren kreative Köpfe gegen das (nicht explizit erlaubte) Nutzen der eigenen Werke für das Training von maschinellen Lernmodellen. Andere, wie die Künstlerin Grimes, ermutigen Fans dazu, ihre Stimme zu nutzen, um damit neue Kunst zu schaffen – für eine Beteiligung.

Große Technologieunternehmen fordern die Regulierung großer Sprachmodelle und die Veröffentlichung von Trainingsdaten. Zum Schutz vor Missbrauch, zur Förderung der Transparenz, zur Vermeidung von Monopolen und natürlich, um die Konkurrenz auszubremsen.

Interessant ist, wie die großen Player mit dem Thema umgehen. Während manche zurückhaltend sind und ihre Modelle nicht veröffentlichen, sondern nur die Ergebnisse, die sie damit erzielen, veröffentlicht bspw. OpenAI ihre Modelle. Hier spielen zwei grundsätzlich unterschiedliche Standpunkte eine Rolle: Ist die Veröffentlichung und damit die Interaktion der weltweiten Öffentlichkeit der Weg zu „sicherer“ KI? Oder sollten Modelle einschränkt und kontrolliert werden, um Missbrauch zu verhindern?

Es bleibt außerdem abzuwarten, wie Gesetzgeber und Regulierungsbehörden mit dem Thema umgehen werden. Sicher ist: Je größer und besser die Datenbasis, desto mächtiger werden die KI-Modelle. Diese Menge an Daten erschwert wiederum den Umgang und die Kontrolle.

Neben diesen weitreichenden Grundsatzdiskussionen müssen wir als Anwendende uns den ganz praktischen Problemen von KI-Modellen bewusst sein. Die Modelle sind nicht perfekt. Sie sind nicht neutral. Sie sind nicht fair. Sie sind nicht einfach zu verstehen. Sie sind nicht einfach zu kontrollieren.

Jede KI-Anwendung unterliegt den Schwächen der Datenbasis, die sich insbesondere durch Verzerrungen oder auch Aktualität der Daten zeigen. Gleichzeitig sind auch LLMs kontextualisierte Prädiktoren, die nicht zwangsläufig die richtigen Informationen liefern. Und – wie jedes maschinelle Lernverfahren unterliegen auch diese Modelle den Eigenarten des Trainingsprozesses, bspw. wie dieser incentiviert wird.

Der bewusste Umgang mit diesen Grenzen ist entscheidend, um lohnende und vor allem unschädliche Anwendungen zu finden.

Mein persönliches (Zwischen-)Fazit?

Ich bin gespannt auf die kommenden Diskussionen, auf die Lösungsansätze in Richtung Regulierung, Datennutzung und Quellennachweisen. Ich freue mich auf kreative Anwendungen und darüber, mehr Köpfen die Möglichkeit zu geben, ihre Ideen umzusetzen.

Ich bin außerdem sicher, dass ich in Zukunft für jeden Anlass den richtigen Grußkarten-Text finden werde.